5 gocce d’acqua e 9 secondi davanti alla TV: ecco quanto costa fare una domanda all’AI. Sembra poco, ma moltiplicato per miliardi di richieste al giorno…

L’Intelligenza Artificiale Generativa (GenAI) è ormai una componente integrante della nostra quotidianità digitale, facilitando compiti e offrendo nuove opportunità. Ma dietro ogni interazione, ogni domanda posta a un chatbot AI come Gemini o ChatGPT, si nasconde un costo meno evidente: un’impronta ecologica fatta di energia, acqua ed emissioni di carbonio. Recentemente, le Big Tech hanno iniziato a sollevare il velo su questi consumi, fornendo i primi dati per comprendere l’impatto reale di questa tecnologia rivoluzionaria.

Analizziamo insieme queste cifre per capire meglio cosa succede “dietro le quinte” del nostro schermo.

Il costo di un singolo prompt: uno sguardo ai dati di Google

L’effetto scala: consumi reali su piattaforme come ChatGPT

L’impronta idrica: dalle gocce alle piscine olimpioniche

La struttura dei consumi e la questione della trasparenza

Il “consumo addizionale” e la sfida della crescita

Limiti dei dati e prospettive future

Il costo di un singolo prompt: uno sguardo ai dati di Google

Google ha recentemente pubblicato il report “Measuring the environmental impact of delivering AI at Google Scale” che svela l’impatto ambientale di una singola interazione testuale con la sua intelligenza artificiale generativa.

Ogni prompt “text-to-text” avvia un processo che consuma 0,24 wattora (Wh) di energia, rilascia 0,03 grammi di Co2e (anidride carbonica equivalente) e richiede 0,26 millilitri d’acqua.

Per fornire un paragone più tangibile, la stessa Google spiega che questa attività equivale a guardare la televisione per 9 secondi o a utilizzare 5 gocce d’acqua. Se un utente medio ponesse circa dieci domande al giorno, l’acqua consumata in un anno raggiungerebbe circa un litro.

Questa cifra, che a prima vista sembra irrilevante, cambia completamente prospettiva se consideriamo che le previsioni dicono che entro fine 2025 le piattaforme di GenAI arriveranno a contare fino a 200 milioni di utenti giornalieri.

Leggi anche: “Come scrivere prompt per creare contenuti con l’AI generativa“

L’effetto scala: consumi reali su piattaforme come ChatGPT

Per comprendere appieno l’entità del fenomeno, è utile considerare i dati di piattaforme con un utilizzo massiccio. OpenAI, ad esempio, ha stimato circa 2,5 miliardi i prompt generati ogni giorno su ChatGPT. Sebbene i numeri specifici di consumo per prompt forniti dal CEO di OpenAI Sam Altman sul suo blog (0,34 Wh e 0,32 millilitri d’acqua) siano leggermente superiori a quelli di Google, non si discostano in modo sostanziale.

Spostando l’attenzione su questi volumi, l’utilizzo giornaliero “base” di ChatGPT assorbe circa 0,85 GWh, arrivando a superare i 310 GWh in un anno. Mettendo in prospettiva questo dato, il consumo energetico annuale della sola piattaforma OpenAI equivale a quello di circa 100 milioni di famiglie italiane.

Considerando che in Italia vivono circa 16 milioni di famiglie, ciò si traduce in un anno di ChatGPT che eguaglia circa 6 anni di consumi energetici per tutte le famiglie italiane.

L’impronta idrica: dalle gocce alle piscine olimpioniche

Non è solo l’energia a essere coinvolta. L’impronta idrica dell’IA è altrettanto significativa. Un solo giorno di funzionamento dell’AI di Altman, con numeri che Google stesso non prevede siano molto diversi per Gemini, comporta il consumo di circa 800 mila litri d’acqua. Su base annuale, questo si traduce in 292 milioni di litri, una quantità paragonabile al contenuto di 117 piscine olimpioniche.

Questo volume d’acqua potrebbe inoltre soddisfare il fabbisogno annuale di acqua potabile di circa 2.000 famiglie italiane. Per un confronto ancora più immediato, il consumo energetico di un singolo prompt di GenAI è paragonabile a circa un secondo di utilizzo di un forno a microonde. Questo significa che, con l’energia usata quotidianamente dall’IA, potremmo cucinare circa 11 milioni di porzioni di lasagne, arrivando a 4,1 miliardi all’anno, quasi una porzione per metà della popolazione mondiale.

La struttura dei consumi e la questione della trasparenza

Google ha analizzato in dettaglio l’allocazione energetica di un prompt:

- il 58% è attribuito ai chip,

- il 25% alla macchina ospitante e alla memoria,

- il 10% alla ridondanza (sistemi di backup) e

- l’8% ai data center per raffreddamento e conversione dell’energia.

Questa granularità suggerisce un tentativo di analisi completa dell’intera catena di produzione di una risposta. È importante notare, tuttavia, che i calcoli sulle emissioni di Google si basano sull’acquisto di energia da fonti rinnovabili attive dal 2010, il che, secondo il Massachussets Institute of Technology, riduce le emissioni dichiarate a un terzo rispetto a quelle di una rete elettrica standard. Google sottolinea anche i notevoli progressi nell’efficienza, riportando una riduzione di 33 volte nel consumo energetico per prompt tra maggio 2024 e maggio 2025.

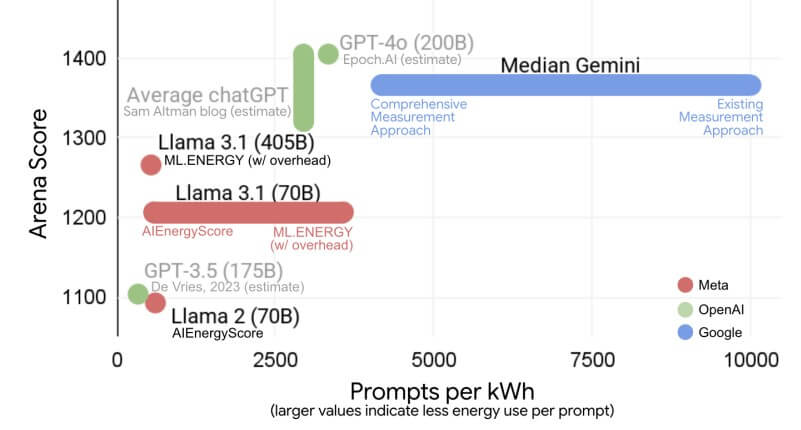

Stima fatta da Google di quanti prompt si possono fare con un Kwh su diverse piattaforme.

Il “consumo addizionale” e la sfida della crescita

Nonostante Jeff Dean, capo scienziato di Google, tenda a minimizzare l’impatto paragonandolo ad attività quotidiane insignificanti come “guardare qualche secondo di tv”, è fondamentale considerare la prospettiva del “consumo addizionale” visto che l’uso dell’IA non sostituisce altre attività, ma si aggiunge ad esse, incrementando il consumo complessivo.

L’interazione con i chatbot è spesso guidata da un “effetto videogame“, dove i sistemi sono progettati per incoraggiare ulteriori domande, portando a un’escalation di prompt e, di conseguenza, di risorse consumate. Questa dinamica si inserisce in un contesto di crescita esponenziale: mentre i consumi energetici “normali” sono aumentati dell’1,5% dopo la pandemia, quelli imputabili ai data center sono lievitati del 20%.

L’Agenzia Internazionale dell’Energia (IEA) prevede che entro il 2026 i data center supereranno i mille TWh, equivalenti all’intero consumo del Giappone. Ciò solleva un interrogativo cruciale sulla capacità dell’efficientamento energetico di contenere un’onda di consumo di tale portata e con un tasso di crescita così rapido.

Limiti dei dati e prospettive future

Nonostante gli sforzi di trasparenza, i report attuali presentano ancora delle lacune che rendono difficile una comprensione completa. Il rapporto di Google, ad esempio, non specifica il numero di prompt giornalieri su Gemini, un dato cruciale per calcoli su larga scala.

Mancano inoltre i costi effettivi delle “Overview” (le sintesi generate dall’IA per le ricerche Google) e, soprattutto, i consumi legati a prompt non testuali, come immagini, audio e video, che sono notevolmente più “cari” in termini energetici. Non viene neanche menzionato il consumo dell’IA in contesti industriali.

Questi punti suggeriscono che l’impronta ecologica dell’IA potrebbe essere ancora più vasta di quanto i dati attuali lascino intendere, rendendo la questione della sostenibilità tecnologica una sfida sempre più pressante per il futuro digitale.

Copywriter, Marketing Specialist e Communication lover. Da sempre appassionata ai libri e alla scrittura, mi occupo di creare contenuti per il web ma non posso rinunciare al mio primo amore: la carta e la penna! Fuori dal web viaggio, cerco di tenermi in forma e soprattutto faccio la mamma.